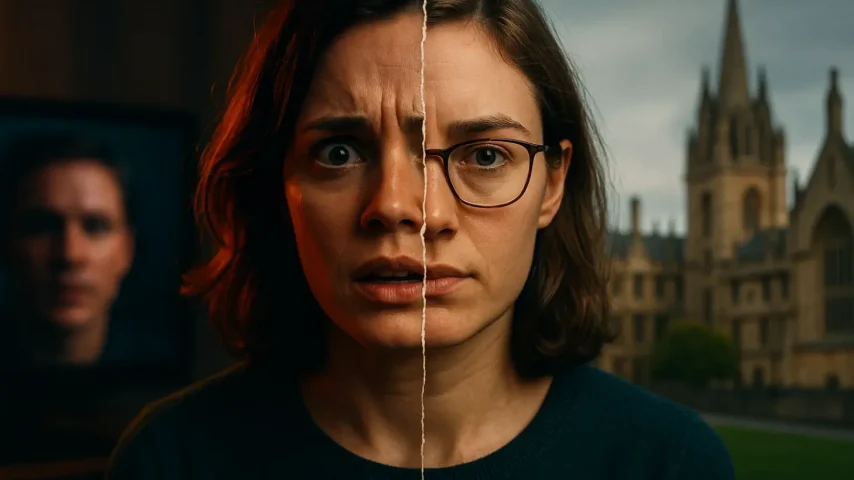

Технология deepfake из любопытного эксперимента быстро превратилась в глобальный вызов для общества. С помощью открытых моделей, включая Stable Diffusion и её производные, стало возможно создавать реалистичные изображения и видео, которые трудно отличить от подлинных. Эксперты Оксфорда бьют тревогу: отсутствие контроля над открытыми SD-моделями способно подорвать доверие к информации, усилить киберугрозы и поставить под удар приватность миллионов людей.

Вопросы этики, безопасности и правового регулирования выходят на первый план, и игнорировать их становится невозможно.

Deepfake и открытые SD-модели: суть угрозы

Открытые модели вроде Stable Diffusion разработаны для творчества, генерации изображений и развития креативных индустрий. Но их доступность делает их инструментом не только для художников и дизайнеров, но и для злоумышленников. Если раньше создание убедительных фальшивых видео требовало значительных технических ресурсов, то теперь достаточно базовых знаний и компьютера средней мощности. Это снижает порог входа и резко увеличивает масштаб угроз.

Особую тревогу вызывает то, что SD-модели могут обучаться на реальных изображениях из социальных сетей. Любой пользователь, ставший объектом подделки, рискует потерять репутацию, а в худшем случае — столкнуться с вымогательством или шантажом. Университетские эксперты подчёркивают: демократизация доступа к таким инструментам без механизмов фильтрации и отслеживания открывает дорогу лавине фейков.

Этические дилеммы и социальные последствия

Внедрение deepfake-технологий поднимает целый пласт этических вопросов. Когда границы реальности стираются, общество начинает терять доверие к визуальным доказательствам. Судебные разбирательства, расследования и даже личные отношения могут оказаться под угрозой.

Для наглядности можно выделить основные социальные риски, связанные с deepfake-контентом:

- подрыв доверия к журналистике и официальным источникам;

- манипуляции общественным мнением и политическими процессами;

- кибербуллинг, направленный на дискредитацию частных лиц;

- рост числа мошеннических схем с использованием поддельных видео.

Эти последствия уже начали проявляться: известны случаи, когда политики, бизнесмены и артисты становились жертвами «цифровых двойников». Ситуация усугубляется тем, что общество пока не выработало устойчивых механизмов защиты от подобных манипуляций.

Международная дискуссия и подходы к регулированию

В середине статьи важно подчеркнуть: мир стоит на пороге выбора между инновациями и безопасностью. Университетские исследователи призывают создать международные стандарты регулирования, которые позволят использовать технологии во благо, но ограничат возможности для злоупотреблений.

Некоторые страны уже предпринимают шаги к созданию нормативных рамок. В Китае введены законы, обязывающие маркировать deepfake-контент. Европейский союз разрабатывает «Акт об искусственном интеллекте», где отдельно рассматриваются вопросы, связанные с генеративными моделями. США пока идут по пути точечных решений, где отдельные штаты вводят собственные запреты.

Для наглядного сравнения рассмотрим таблицу с кратким обзором мер разных регионов:

| Регион | Подход к регулированию | Особенности |

|---|---|---|

| Китай | Жёсткий контроль | Обязательная маркировка deepfake |

| ЕС | Комплексный закон | «Акт об ИИ» с акцентом на прозрачность |

| США | Локальные инициативы | Разные правила в отдельных штатах |

| Великобритания | Подготовка кодекса | Добровольные стандарты для разработчиков |

Эта таблица демонстрирует, что консенсуса пока нет: одни государства выбирают строгий контроль, другие полагаются на этику самих разработчиков. Однако отсутствие глобального подхода создаёт пространство для правовых «лазеек».

Технологические решения и возможные барьеры

Наряду с правовыми инструментами активно обсуждаются и технические меры. Исследователи предлагают внедрять «цифровые водяные знаки» в создаваемые изображения и видео, что позволит легче идентифицировать подделки. Другой путь — разработка систем, способных автоматически распознавать deepfake по микроскопическим искажениям изображения или звука.

Сторонники инноваций указывают, что важно сохранять баланс: чрезмерный контроль может ограничить творчество и замедлить прогресс в области искусственного интеллекта. Но без барьеров мы рискуем оказаться в мире, где «ничему нельзя верить». Именно поэтому обсуждение будущего SD-моделей выходит далеко за рамки академических кругов и становится предметом общественного диалога.

Чтобы показать спектр возможных барьеров, эксперты выделяют несколько направлений:

- создание глобальных стандартов маркировки контента;

- внедрение этических кодексов для разработчиков;

- развитие технологий автоматического распознавания подделок;

- инвестиции в цифровую грамотность населения.

Этот список отражает комплексный подход, который включает как технические, так и образовательные меры. Только их синергия может обеспечить устойчивую защиту общества.

Роль медиа и образовательных программ

Медиа — ключевой элемент в формировании общественного мнения о deepfake. Именно журналисты могут разоблачать поддельные материалы и информировать аудиторию о реальных рисках. Однако для этого необходима собственная подготовка: редакции должны внедрять технологии проверки подлинности визуального контента.

Не менее важным направлением является образование. Если люди научатся критически воспринимать цифровую информацию, они будут менее уязвимы перед манипуляциями. Университеты, школы и онлайн-платформы всё активнее внедряют курсы по медиаграмотности.

Эксперты отмечают, что устойчивость общества во многом зависит от уровня информированности граждан. Технологии будут развиваться, но именно подготовленный зритель сможет отличить правду от иллюзии. Поэтому образовательные инициативы должны стать частью национальных стратегий безопасности.

Заключение: поиск баланса между инновацией и ответственностью

Deepfake — это не просто новая технология, а вызов для всей системы доверия в цифровую эпоху. Открытые SD-модели несут как огромный потенциал для развития креативных индустрий, так и серьёзные риски для безопасности и этики. Эксперты Оксфорда правы: необходим контроль, но этот контроль должен быть разумным и гибким.

Итоговый выбор заключается в балансе: ограничивать злоупотребления, но сохранять свободу для созидательного использования. Только так общество сможет извлечь пользу из инноваций, не теряя при этом основу — доверие к реальности.